تیمی از دانشمندان مؤسسه علوم و فناوری پیشرفته کره (KAIST) تراشه هوش مصنوعی «مکمل-ترانسفورماتور» خود را در کنفرانس بینالمللی مدارهای حالت جامد اخیر (ISSCC) در سال 2024 شرح دادند. ادعا می شود تراشه جدید C-Transformer اولین تراشه شتاب دهنده هوش مصنوعی با قدرت فوق العاده کم در جهان است که قادر به پردازش مدل زبان بزرگ (LLM) است.

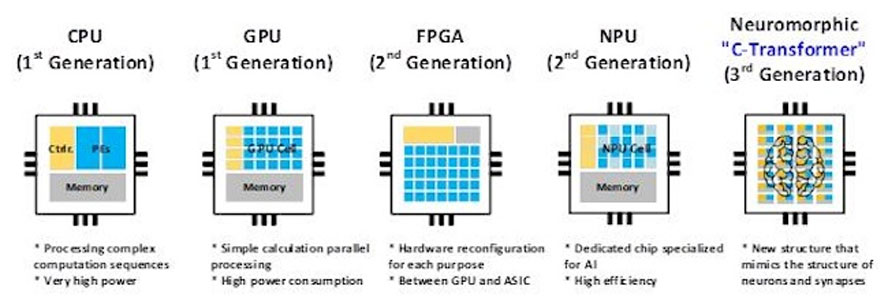

در یک بیانیه مطبوعاتی، محققان انویدیا را شرمنده کردند و ادعا کردند که C-Transformer 625 برابر انرژی کمتری مصرف می کند و 41 برابر کوچکتر از پردازنده گرافیکی A100 Tensor Core تیم سبز است. همچنین نشان میدهد که دستاوردهای تراشههای ساختهشده سامسونگ عمدتاً از فناوری پردازش نورومورفیک اصلاحشده ناشی میشود.

اگرچه به ما گفته میشود که تراشه KAIST C-Transformer میتواند همان وظایف پردازش LLM را مانند یکی از پردازندههای گرافیکی قدرتمند A100 انویدیا انجام دهد، اما هیچکدام از مطالب مطبوعاتی و کنفرانسی ما هیچ معیار عملکرد مقایسهای مستقیمی ارائه نکردهایم. این یک آمار قابل توجه است که به دلیل نبود آن مشخص است، و افراد بدبین احتمالاً حدس می زنند که مقایسه عملکرد هیچ لطفی به C-Transformer نمی کند.

گالری فوق دارای «عکس تراشه» و خلاصه ای از مشخصات پردازنده است. می بینید که C-Transformer در حال حاضر بر اساس فرآیند 28 نانومتری سامسونگ ساخته شده و دارای مساحت قالب 20.25 میلی متر مربع است. حداکثر فرکانس 200 مگاهرتز کار می کند و کمتر از 500 میلی وات مصرف می کند. در بهترین حالت، می تواند به 3.41 تاپ برسد. در ارزش اسمی، 183 برابر کندتر از 624 TOPS ادعا شده کارت Nvidia A100 PCIe است (اما ادعا می شود تراشه KAIST 625 برابر انرژی کمتری مصرف می کند). با این حال، ما ترجیح می دهیم نوعی مقایسه عملکرد معیار را به جای نگاه کردن به تاپ های ادعا شده هر پلتفرم انجام دهیم.

معماری تراشه C-Transformer جالب توجه است و با سه بلوک اصلی عملکردی مشخص می شود. در مرحله اول، یک هسته همگن DNN-Transformer / Spiking-Transformer Core (HDSC) با یک واحد ضرب-انباشت ترکیبی (HMAU) برای پردازش موثر انرژی توزیع به صورت پویا در حال تغییر وجود دارد. در مرحله دوم، ما یک واحد حدس و گمان خروجی (OSSU) برای کاهش تأخیر و محاسبات پردازش دامنه سنبله داریم. ثالثاً، محققان یک واحد تولید وزن ضمنی (IWGU) با فشردهسازی علامت گسترده (ESC) را برای کاهش مصرف انرژی به حافظه خارجی (EMA) اجرا کردند.

توضیح داده شده است که تراشه C-Transformer فقط مقداری پردازش نورومورفیک خارج از قفسه را به عنوان “سس ویژه” خود برای فشرده سازی پارامترهای بزرگ LLM اضافه نمی کند. طبق بیانیه مطبوعاتی KAIST، قبلاً، فناوری محاسبات نورومورفیک برای استفاده در LLM ها به اندازه کافی دقیق نبود. با این حال، تیم تحقیقاتی میگوید که “در بهبود دقت فناوری برای مطابقت با DNN (شبکههای عصبی عمیق) موفق شدهاند.

اگرچه به دلیل عدم مقایسه مستقیم با شتاب دهنده های هوش مصنوعی استاندارد صنعت، ابهاماتی در مورد عملکرد این اولین تراشه C-Transformer وجود دارد، اما به سختی می توان ادعاها را مبنی بر اینکه گزینه جذابی برای محاسبات موبایلی خواهد بود، رد کرد. همچنین دلگرم کننده است که محققان با تراشه آزمایشی سامسونگ و آزمایش گسترده GPT-2 تا این حد پیش رفته اند.

مرجع اخبار سخت افزار کامپیوترایران

تحریریه Techpowerup